更快的分析意味着对 AI 开发有更深入的见解

更快的训练速度带来更先进的 AI 模型

更快的推理通过最大化系统利用率提高投资回报率

每块 GPU 支持 12 个 NVLink 连接,GPU 至 GPU 带宽高达 600 GB/s

双向带宽高达 4.8 TB/s,比上一代产品高出 2 倍

双向带宽峰值高达 450 GB/s

以 3.2 倍核心数量满足超密集的 AI 作业

带宽峰值高达 25 GB/s,比三代 NVME SSD 快两倍

DGX A100 采用多层方法为 AI 部署提供了最强大的安全性,该方法可以保护所有主要的硬件和软件组件,包括自加密驱动、签名软件容器、安全管理和监控等。

借助 MIG,可将 DGX A100 中的八块 A100 GPU 配置为多达 56 个 GPU 实例,每个实例都具有自己的高带宽内存,高速缓存和计算核心,完全隔离。这使管理员可合理调配 GPU 资源,确保多个工作负载的服务质量。

DGX A100 中的第三代 NVIDIA® NVLink® 使 GPU 至 GPU 直接带宽提高一倍,达到600 GB/s,几乎比 PCIe 4.0 高出 10 倍。DGX A100 还采用新一代 NVIDIA NVSwitch™,其速度是前一代的两倍。

DGX A100 采用最新 Mellanox ConnectX-6 VPI HDR InfiniBand/以太网适配器,每个适配器的运行速度高达200 Gb/s,为大规模 AI 工作负载创建高速网络结构。

DGX A100 集成经过测试和优化的 DGX 软件堆栈,包括通过 AI 调整的基本操作系统、所有必需的系统软件以及 GPU 加速应用、预训练的模型以及 NGC™ 提供的更多功能。

DGX A100 采用多层方法为 AI 部署提供了最强大的安全性,该方法可以保护所有主要的硬件和软件组件,包括自加密驱动、签名软件容器、安全管理和监控等。

| GPUs | 8块 NVIDIA® A100 Tensor Core GPUs |

| GPU 显存 | 共 320GB |

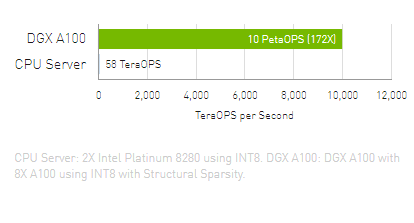

| 性能 |

5 petaFLOPS AI 10 petaOPS INT8 |

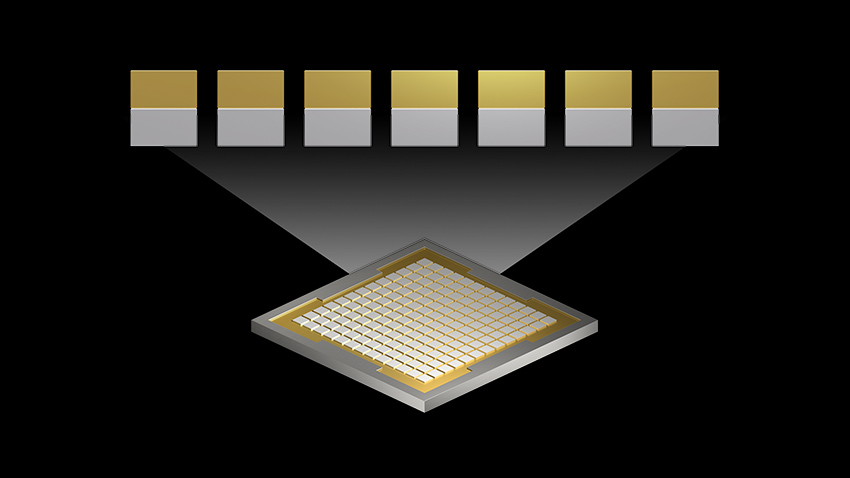

| NVSwitches | 6 |

| 最大功率 | 6.5kW max |

| CPU |

Dual AMD Rome 7742, 128 cores total, 2.25 GHz (base), 3.4 GHz (max boost) |

| 系统内存 | 1TB |

| 网络 |

8x Single-Port Mellanox ConnectX-6 VPI 200Gb/s HDR InfiniBand 1x Dual-Port Mellanox ConnectX-6 VPI 10/25/50/100/200Gb/s Ethernet |

| 存储空间 |

OS: 2x 1.92TB M.2 NVME drives Internal Storage: 15TB (4x 3.84TB) U.2 NVME drives |

| 软件 | Ubuntu Linux OS |

| 系统重量 | 123 千克 |

| 系统尺寸 |

高:264.0 毫米 宽:482.3 毫米 长:897.1 毫米 |

| 运行温度范围 | 5°C 至 30°C |

产品咨询热线

01082112760