智能视频分析(IVA)已经渗透到各行各业的诸多应用中。虽然渗透增长很快,但在边缘设备中实施先进IVA时,开发的便捷性仍然是一大挑战。

Hailo-8™人工智能加速模块可用于增强启用人工智能的现有IVA应用,并用于智能视频分析解决方案的开发和原型,这得益于其功能:

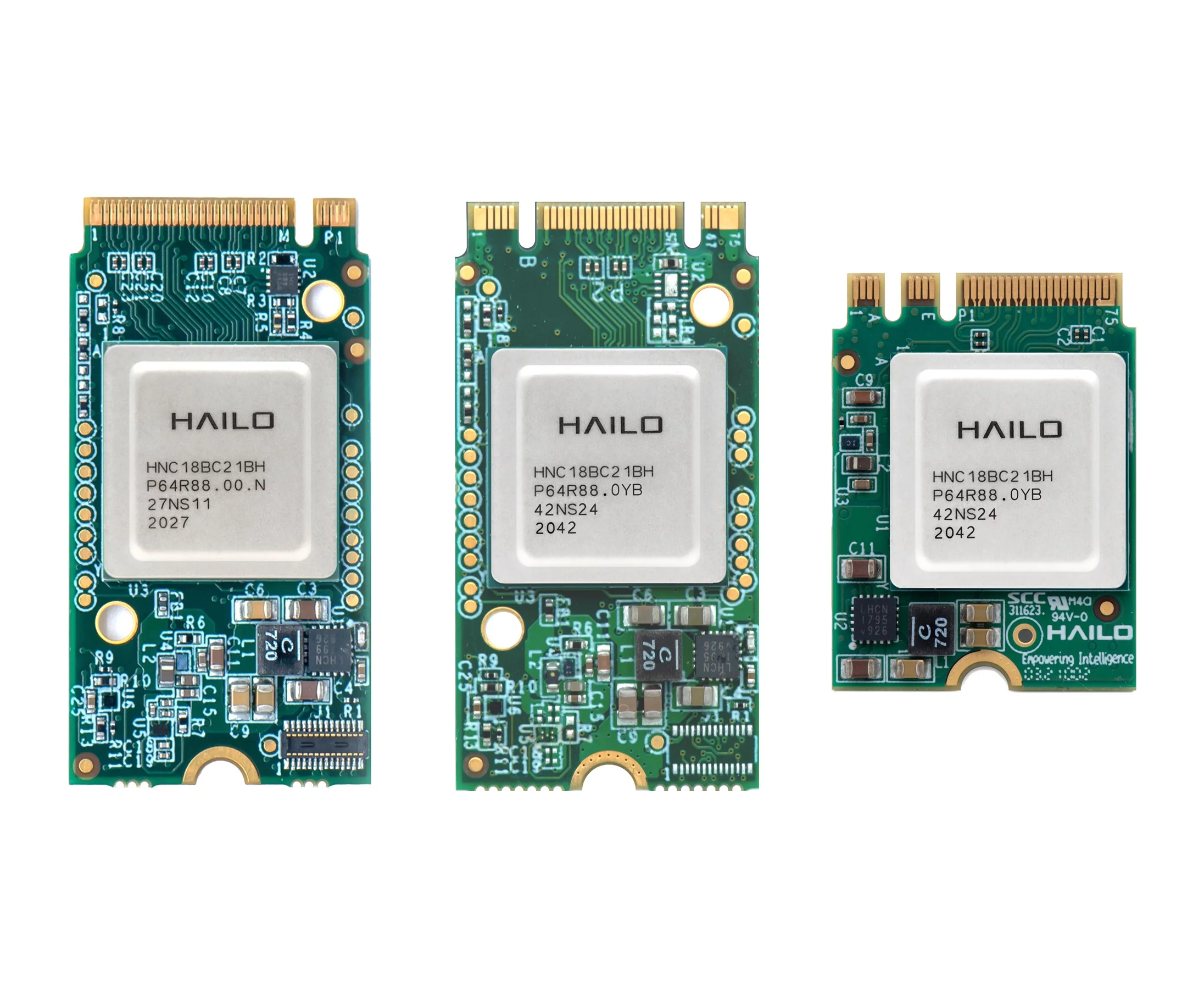

Hailo-8™ M.2 模块是一款用于AI应用的AI加速器模块,与NGFF M.2接口标准中的M、B+M和A+E的键位兼容。该AI模块基于每秒 26 兆次运算 (TOPS) 的 Hailo-8™ AI处理器,具有高功率效率。M.2 AI加速器配备了全部PCIe Gen-3.0 两通道接口(M键位模块使用4通道接口),可为边缘设备提供前所未有的AI性能。M.2模块可装备于市面上任何自带M.2插槽的边缘设备上,以实现在广泛细分领域执行实时低功耗的神经网络推理。利用Hailo强大的数据流编译器及其对标准AI架构的支持,用户可轻松地将他们的神经网络模型导入到Hailo-8中,并迅速向市场推出高性能的AI产品。

|

Form Factor |

M.2 Key M |

M.2 Key B+M |

M.2 Key A+E |

|

AI Processor |

Hailo-8™ AI processor with up to 26 TOPS and best-in-class power efficiency |

||

|

Dimensions |

22 x 42 mm |

22 x 30 mm |

|

|

Interface |

PCIe Gen-3.0, 4 lanes (up to 32 Gbs) |

PCIe Gen-3.0, 2 lanes (up to 16 Gbs) |

|

|

Supported Frameworks |

TensorFLow, TensorFlow Lite, ONNX, Keras, Pytorch |

||

|

Supported OS |

Linux, Windows |

||

|

Certification |

CE, FCC |

||

Hailo-8R™ Mini PCIe 模块是一款用于AI应用的AI加速器模块,与PCI Express Mini (mPCIe)键位兼容。Mini PCIe AI加速器可为边缘设备提供行业领先的AI性能 — 高达每秒 13 兆次的运算 (TOPS) 能力和行业领先的功率效率。该模块可装备于市面上任何自带mPCIe Full-Mini插槽的边缘设备上,以实现在广泛细分领域执行实时低功耗的神经网络推理。利用Hailo强大的数据流编译器及其对标准AI架构的支持,用户可轻松地将他们的神经网络模型导入到Hailo-8中,并迅速向市场推出高性能的AI产品。

Hailo-8™入门套件包括:

Hailo-8交叉编译实例

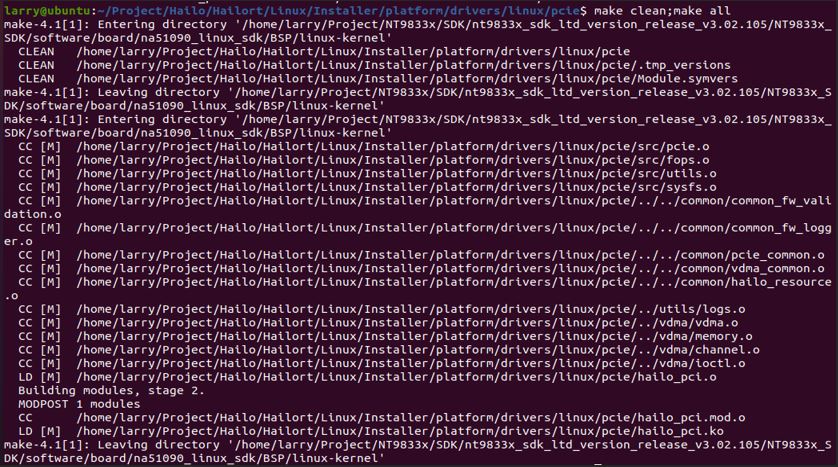

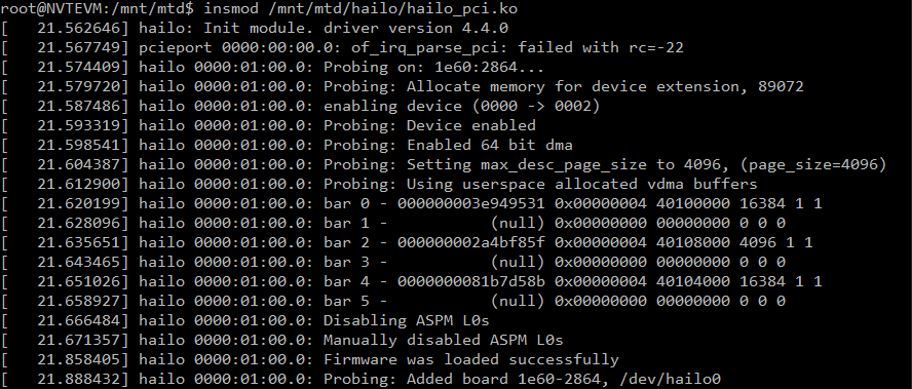

cd $(Hailort)/Linux/Installer/platform/drivers/linux/pcie

ii. 修改Makefile,將$(KERNEL_DIR)指向主板核心目录

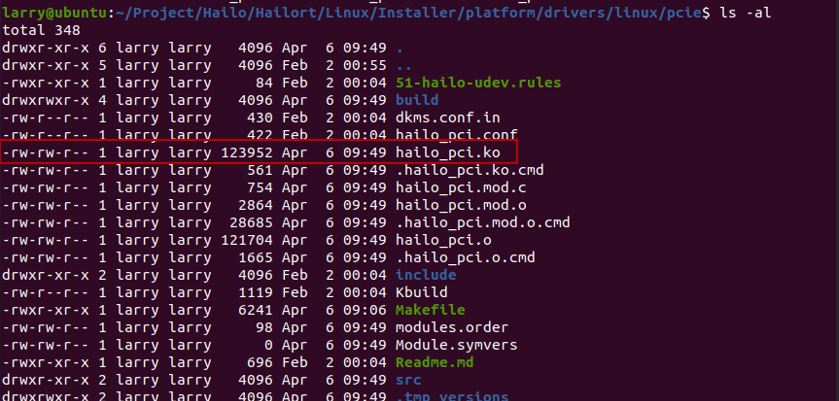

iii. 执行make clean;make all完成之后可在同目录得到ko

2. 编译hailort_sources

i. 切换cmake交叉编译目录。cd $(Hailort)/Linux/Installer/platform/hailort_sources/hailort/libhailort/cmake/toolchains

ii. 新增aarch64-ca53.cmake,内容如下图所示。

cd $(Hailort)/Linux/Installer/platform/hailort_sources

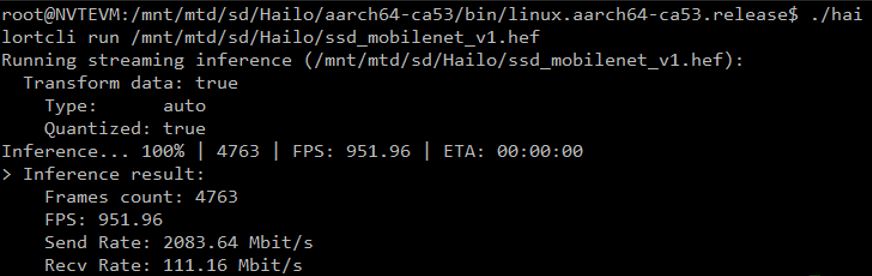

iv. 使用cmake编译。cmake -H. -Bbuild -DCMAKE_BUILD_TYPE=Release -DHAILO_SKIP_PYBIND=1 \

-DHAILO_SKIP_UT=1 -DHAILO_BUILD_EXAMPLES=0 -DHAILO_TOOLCHAIN=linux.aarch64-ca53 && cmake --build build

产品咨询热线

01082112760